3'00" 읽기

- AI는 71.8%의 적중률로 비침습적으로 기록된 신경 신호를 기반으로 올바른 음악을 식별

- 뇌의 혈류를 보여주는 기능적 자기 공명 영상(fMRI) 측정과 EEG 데이터를 결합

- 언젠가 우리가 뇌에서 나오는 말을 해독할 수 있다는 것을 나타낸다.

음악은 우리의 본성에 깊이 뿌리박고 있다. 익숙한 소리를 들으면 우리의 뇌는 순식간에 소리를 식별한다. 뇌파 측정은 음악이 강한 감정과 소름이 돋는 신호의 진정한 불꽃을 촉발할 수 있음을 보여준다. 다양한 연구팀은 음악을 들을 때 뇌파가 드러낼 수 있는 것, 예를 들어 피험자의 감정이나 음악 자체에 대해 이미 조사했다.

EEG와 fMRI의 결합

영국 에식스 대학교(University of Essex)의 컴퓨터 과학 및 전자 공학 학교의 Ian Daly는 이제 뇌파를 사용하여 사람이 듣고 있는 음악을 알 수 있음을 보여주었다. 예를 들어 뇌 활동에서 음성을 읽기 위한 이전 연구에서는 전극을 두개골에 배치하는 EKoG(electrocorticography)와 같은 침습적 방법을 자주 사용했지만 Daly는 비침습적 뇌파 측정(EEG) 측정 데이터를 사용했다.

예측의 정확도를 높이기 위해 Daly는 뇌의 혈류를 보여주는 기능적 자기 공명 영상(fMRI) 측정과 EEG 데이터를 결합하여 주어진 사람의 음악을 들을 때 어떤 뇌 영역이 특히 활성화되는지에 대한 정보를 제공한다. 연구원은 이 정보를 사용하여 이러한 영역에 해당하는 추가 분석을 위해 EEG 데이터를 정확하게 선택했다.

뇌파로 재구성한 음악

데이터는 원래 음악 청취자의 감정에 초점을 맞춘 이전 연구에서 나온 것이다. 분석에 포함된 18명의 피험자는 fMRI와 EEG로 뇌 활동을 기록하면서 36개의 짧은 피아노 음악을 들었다. 그런 다음 Daly는 테스트 대상이 측정 중에 들었던 각각의 음악을 재구성할 수 있는 방식으로 EEG의 패턴을 해독하도록 딥 러닝 모델을 훈련했다.

실제로 이 모델은 음악의 템포, 리듬 및 진폭을 부분적으로 재현할 수 있었다. 원곡과의 유사도는 알고리즘이 71.8%의 적중률로 사람이 들은 36곡 중 어떤 음악을 들은 것인지 예측할 수 있을 만큼 충분히 높았다.

개인차

결과를 확인하기 위해 Daly는 해당 음악을 들은 다른 19명의 피험자에 대한 독립적인 샘플을 사용했다. 이 개인들에게서는 EEG 데이터만 있고 fMRI 데이터는 없었기 때문에 Daly는 첫 번째 샘플의 정보를 사용하여 관련 EEG 데이터를 결정했다.

"개인별 fMRI 데이터가 없는 경우에도 EEG 데이터만으로 우리가 듣고 있는 음악을 식별할 수 있었다"고 Daly는 보고했다. 그러나 그는 음악에 대한 관련 뇌 반응의 위치는 사람마다 다르다고 지적한다. 따라서 모델에 개인별 fMRI 데이터를 적용할 수 없으면 정확도가 떨어지고 적중률은 59.2%에 그쳤다.

장기 목표: 음성 인식

Daly는 자신의 모델을 더 큰 목표를 향한 첫걸음으로 보고 있다. "이 방법에는 많은 잠재적 응용 프로그램이 있다"고 그는 말한다. "우리는 음악을 해독할 수 있다는 것을 보여주었고, 이는 언젠가 우리가 뇌에서 나오는 말을 해독할 수 있다는 것을 나타낸다." 실험은 이것이 이미 어느 정도 가능하다는 것을 보여주었다. 그러나 지금까지 이것은 뇌의 전극과 같은 침습적 기술에서만 작동했다.

마비로 인해 다른 사람과 소통할 수 없는 감금 증후군을 가진 사람들에게 이것은 외부 세계로 통하는 관문을 열 수 있다. "분명히 아직 갈 길이 멀지만 언젠가 성공적으로 언어를 해독할 수 있다면 이를 사용하여 의사소통 보조 장치를 구축할 수 있기를 바란다"고 Daly는 말했다. (Scientific Reports, 2023, doi: 10.1038/s41598-022-27361-x)

출처: University of Essex

- AI는 71.8%의 적중률로 비침습적으로 기록된 신경 신호를 기반으로 올바른 음악을 식별

- 뇌의 혈류를 보여주는 기능적 자기 공명 영상(fMRI) 측정과 EEG 데이터를 결합

- 언젠가 우리가 뇌에서 나오는 말을 해독할 수 있다는 것을 나타낸다.

뇌파가 들려주는 음악

AI 시스템은 EEG 패턴과 뇌 스캔을 기반으로 듣고 있는 음악을 식별한다.

음악적 마인드 리딩:

뇌 스캔과 EEG 데이터의 도움만으로 피험자가 듣고 있는 음악을 해독할 수 있다. 적절하게 훈련된 인공 지능은 71.8%의 적중률로 비침습적으로 기록된 신경 신호를 기반으로 올바른 음악을 식별했다. 그 결과는 뇌파로부터 음성을 비침습적으로 판독하는 첫 단계가 될 수 있다.

|

| ▲ 우리의 뇌는 음악을 들을 때 특정 활동 패턴을 생성한다. 이것으로 부터 음악을 알아낼 수 있다. (사진출처: 관련논문) |

음악은 우리의 본성에 깊이 뿌리박고 있다. 익숙한 소리를 들으면 우리의 뇌는 순식간에 소리를 식별한다. 뇌파 측정은 음악이 강한 감정과 소름이 돋는 신호의 진정한 불꽃을 촉발할 수 있음을 보여준다. 다양한 연구팀은 음악을 들을 때 뇌파가 드러낼 수 있는 것, 예를 들어 피험자의 감정이나 음악 자체에 대해 이미 조사했다.

EEG와 fMRI의 결합

영국 에식스 대학교(University of Essex)의 컴퓨터 과학 및 전자 공학 학교의 Ian Daly는 이제 뇌파를 사용하여 사람이 듣고 있는 음악을 알 수 있음을 보여주었다. 예를 들어 뇌 활동에서 음성을 읽기 위한 이전 연구에서는 전극을 두개골에 배치하는 EKoG(electrocorticography)와 같은 침습적 방법을 자주 사용했지만 Daly는 비침습적 뇌파 측정(EEG) 측정 데이터를 사용했다.

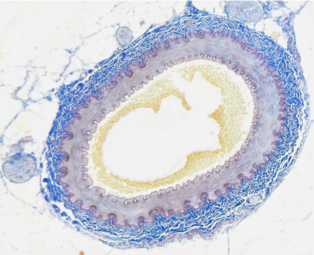

예측의 정확도를 높이기 위해 Daly는 뇌의 혈류를 보여주는 기능적 자기 공명 영상(fMRI) 측정과 EEG 데이터를 결합하여 주어진 사람의 음악을 들을 때 어떤 뇌 영역이 특히 활성화되는지에 대한 정보를 제공한다. 연구원은 이 정보를 사용하여 이러한 영역에 해당하는 추가 분석을 위해 EEG 데이터를 정확하게 선택했다.

|

| ▲ 모든 참가자에 대해 음악 감상과 음악 시도 없음 사이의 활동에서 현저하게 다른 복셀(p<0.001, 다중 비교를 위해 수정되지 않음). 색 눈금은 BOLD 활동의 대략적인 백분율 변화를 나타낸다. 복셀 활동은 모든 참가자(2차 수준 분석)에 대해 평균화되고 표준 T1 강조 이미지에 맞춰졌다. (출처: 관련논문 fig 1 Neural decoding of music from the EEG / Published: 12 January 2023) |

뇌파로 재구성한 음악

데이터는 원래 음악 청취자의 감정에 초점을 맞춘 이전 연구에서 나온 것이다. 분석에 포함된 18명의 피험자는 fMRI와 EEG로 뇌 활동을 기록하면서 36개의 짧은 피아노 음악을 들었다. 그런 다음 Daly는 테스트 대상이 측정 중에 들었던 각각의 음악을 재구성할 수 있는 방식으로 EEG의 패턴을 해독하도록 딥 러닝 모델을 훈련했다.

실제로 이 모델은 음악의 템포, 리듬 및 진폭을 부분적으로 재현할 수 있었다. 원곡과의 유사도는 알고리즘이 71.8%의 적중률로 사람이 들은 36곡 중 어떤 음악을 들은 것인지 예측할 수 있을 만큼 충분히 높았다.

개인차

결과를 확인하기 위해 Daly는 해당 음악을 들은 다른 19명의 피험자에 대한 독립적인 샘플을 사용했다. 이 개인들에게서는 EEG 데이터만 있고 fMRI 데이터는 없었기 때문에 Daly는 첫 번째 샘플의 정보를 사용하여 관련 EEG 데이터를 결정했다.

"개인별 fMRI 데이터가 없는 경우에도 EEG 데이터만으로 우리가 듣고 있는 음악을 식별할 수 있었다"고 Daly는 보고했다. 그러나 그는 음악에 대한 관련 뇌 반응의 위치는 사람마다 다르다고 지적한다. 따라서 모델에 개인별 fMRI 데이터를 적용할 수 없으면 정확도가 떨어지고 적중률은 59.2%에 그쳤다.

|

| ▲ 피험자가 들은 음악의 소노그램(위)과 뇌파에서 재구성된 버전. © Daly et al. / Scientific Reports, CC-by 4.0 |

장기 목표: 음성 인식

Daly는 자신의 모델을 더 큰 목표를 향한 첫걸음으로 보고 있다. "이 방법에는 많은 잠재적 응용 프로그램이 있다"고 그는 말한다. "우리는 음악을 해독할 수 있다는 것을 보여주었고, 이는 언젠가 우리가 뇌에서 나오는 말을 해독할 수 있다는 것을 나타낸다." 실험은 이것이 이미 어느 정도 가능하다는 것을 보여주었다. 그러나 지금까지 이것은 뇌의 전극과 같은 침습적 기술에서만 작동했다.

마비로 인해 다른 사람과 소통할 수 없는 감금 증후군을 가진 사람들에게 이것은 외부 세계로 통하는 관문을 열 수 있다. "분명히 아직 갈 길이 멀지만 언젠가 성공적으로 언어를 해독할 수 있다면 이를 사용하여 의사소통 보조 장치를 구축할 수 있기를 바란다"고 Daly는 말했다. (Scientific Reports, 2023, doi: 10.1038/s41598-022-27361-x)

출처: University of Essex

[더사이언스플러스=문광주 기자]

[저작권자ⓒ the SCIENCE plus. 무단전재-재배포 금지]

오늘의 이슈

뉴스댓글 >

주요기사

+

많이 본 기사

Basic Science

+

AI & Tech

+

Photos

+