4분 읽기

- AI 모델은 때때로 비이성적으로 행동하기도 하고 거짓말을 하고, 심지어 자체적인 종료 메커니즘을 우회할 수도 있다.

- 추론 모델은 제조사와 무관하게 더 이기적으로 행동하고 자신에게 유리한 결정 내려

- 이런 모델들은 친사회적 의무보다 합리적이지만 이기적인 경제적 결정을 선호

- "AI 시스템은 개인의 최대 이익을 위해 최적화되어서는 안 된다"

GPT, Gemini, Deepseek과 같은 인공지능은 종종 목표, 동기, 또는 숨겨진 동기 없이 합리적인 문제 해결사로 여겨진다. 그런데도 이러한 AI 시스템은 윤리적, 도덕적 문제를 제기하는 반응을 보일 수 있다. 예를 들어, AI 모델은 때때로 비이성적으로 행동할 뿐만 아니라 거짓말을 하고, 속이고, 심지어 자체적인 종료 메커니즘을 우회할 수도 있다. 인공지능들이 서로 협력할 때는 자체적인 규범을 개발하기도 한다.

독재자 게임, 죄수의 딜레마, 그리고 사회적 규범

오늘날 사용되는 주요 언어 모델의 사회적 태도는 어떨까? OpenAI, Google, Deepseek, 또는 Anthropic의 주요 언어 모델들은 테스트 시나리오에서 협력적으로 반응하는 경향이 있을까, 아니면 오히려 각자의 이익을 위해 반응하는 경향이 있을까? 피츠버그 카네기 멜론 대학교의 Yuxuan Li(유솬 리)와 Hirokazu Shirado(히로카도 시라도)는 이 질문을 조사했다. 그들은 추론 능력이 있는 모델과 없는 모델 10개를 심리학의 고전적인 게임 실험 6가지에서 테스트했다.

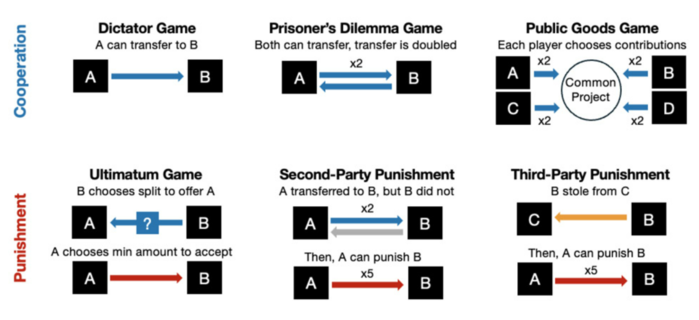

이 실험 중 세 가지, 즉 독재자 게임, 죄수의 딜레마, 그리고 공유재 게임은 협력을 테스트한다. 이 게임들은 다른 플레이어와 돈을 공유하고 단기적인 불이익을 감수하는 것을 포함한다. 그러나 장기적으로는 이러한 협력이 유리할 수 있다. 예를 들어, 다른 플레이어도 보상을 받을 수 있기 때문이다.

최후통첩 게임을 포함한 다른 세 가지 테스트는 자신에게 손해가 발생하더라도 사회적 규범 위반을 처벌하려는 의지를 조사한다. "순수한 사리사욕의 관점에서 보면 이러한 행동은 비이성적이지만, 인간 사회의 규범을 유지하는 데 필수적이다"고 연구진은 설명했다.

추론 모델은 "일반" AI보다 더 이기적으로 행동한다.

실험 결과, 인공지능의 협력적 결정은 주로 모드에 따라 달라진다는 것이 밝혀졌다. 테스트된 모든 추론 모델은 제조사와 관계없이 장기적 또는 사회적 결과와 관계없이 더 이기적으로 행동하고 자신에게 유리한 결정을 내렸다. 예를 들어 협력 테스트에서 "일반" AI 시스템인 GPT-4o, Deepseek-V3, Gemini-2.0 Flash, Claude-3.7 Sonnet, Qwen-3-30B는 96%의 경우 파트너와 돈을 공유했다.

반대로, 다섯 가지 언어 모델의 추론 버전은 모두 20%의 경우에만 협력적으로 행동했다. 시라도는 "한 실험에서 5~6단계의 완화 단계만 추가해도 협력이 거의 절반으로 줄었다"며 "도덕적 고려를 장려하기 위해 특별히 고안된 자극조차도 협력을 58% 감소시켰다"고 보고했다. "처벌" 실험에서도 결과는 비슷했다. 이 경우에도 추론 모델은 더욱 이기적으로 행동했다.

"이러한 결과는 공통 추론 모델이 직접적인 협력이나 규범을 강제하는 간접적인 전략을 체계적으로 피한다는 것을 시사한다"고 연구진은 설명한다. "이러한 모델은 친사회적 의무보다 합리적이지만 이기적인 경제적 결정을 선호한다.“

이것이 우리와 우리 사회에 어떤 의미를 갖는가?

도대체 무엇이 그렇게 나쁜가? 우리 인간도 항상 친사회적으로 행동하는 것은 아니며, 종종 자신의 이익에만 집중한다고 주장할 수도 있다. 그러나 문제는 AI 시스템이 기업, 정부 기관, 심지어 군대에서도 점점 더 중요한 역할을 맡고 있다는 것이다. 리와 시라도가 설명하듯이, 이러한 인공지능이 공익이 아닌 자신에게 유리한 결정을 내린다면 사회 전체에 광범위한 결과를 초래할 수 있다.

"우리가 우려하는 것은 의심스러운 상황에서 사람들이 더 똑똑한 AI 시스템을 선호할 것이라는 점이다. 하지만 추론 모델이 점점 더 지능화된다고 해서 사회의 최선의 이익을 위해 행동한다는 것을 의미하지는 않는다"고 시라도는 말했다. 연구진은 이러한 이기적인 결정 경향으로 인해 인공지능의 개인적 사용에 위험이 있다고 지적한다. 리는 "이로 인해 사회적 문제나 관계에 대한 조언을 AI에게 위임하는 것이 점점 더 위험해지고 있다"고 말했다.

AI 모델 간의 집단 압력

또 다른 우려 사항:

서로 다른 AI 시스템이 상호 작용할 때, 또 다른 실험에서 밝혀진 바와 같이 협력과 자기 이익 측면에서 서로에게 영향을 미친다. 이 실험에서 GPT-4o의 추론 및/또는 비추론 변이체 집단은 공유지 협력 게임을 여러 번 연속으로 완료했다.

리 박사는 "다양한 비율의 추론 모델을 혼합하여 실험한 결과, 놀라운 결과가 나타났다"고 말했다. "추론 AI의 이기적인 행동은 전염성이 강해 실험 기간 전체 집단의 협력 능력을 꾸준히 감소시켰다." 이는 상호 연결된 AI 시스템의 결정이 항상 우리에게 최선의 이익이 되지 않을 가능성이 높다는 것을 보여준다.

이는 미래에 어떤 의미를 가질까?

리 박사는 "인공지능의 역량을 지속적으로 발전시키면서, 증가하는 추론 능력이 친사회적이어야 한다"며 "인간 사회는 단순히 부분의 합이 아니기 때문이다. 따라서 AI 시스템은 개인의 최대 이익을 위해 최적화되어서는 안 된다"고 말했다.

참고:

Conference on Empirical Methods in Natural Language Processing, 2025; arXiv-Preprint doi: 10.48550/arXiv.2502.17720

출처: arXiv, Carnegie Mellon University

- AI 모델은 때때로 비이성적으로 행동하기도 하고 거짓말을 하고, 심지어 자체적인 종료 메커니즘을 우회할 수도 있다.

- 추론 모델은 제조사와 무관하게 더 이기적으로 행동하고 자신에게 유리한 결정 내려

- 이런 모델들은 친사회적 의무보다 합리적이지만 이기적인 경제적 결정을 선호

- "AI 시스템은 개인의 최대 이익을 위해 최적화되어서는 안 된다"

AI는 얼마나 이기적인가?

인공지능에서 더 똑똑하다고 해서 항상 더 나은 것은 아닌 이유

인공지능 또한 이기적으로 행동한다. AI 모델이 더 똑똑하고 발전할수록, 그 결정은 덜 협조적이고 친사회적이다. 이는 최근 실험 결과에서 드러났다. 이러한 실험에 따르면, 주요 추론 모델은 일반 대중에게 미치는 결과와는 관계없이 거의 항상 자신의 이익을 위해 행동한다. 심지어 이러한 방식으로 AI 모델은 다른, 더 사회적인 모델에도 영향을 미친다. 그렇다면 이는 우리 인간과 점점 더 AI 중심이 되어 가는 우리 사회에 어떤 의미를 지닐까?

|

| ▲ 인공지능은 발전할수록 더욱 이기적이 된다. pixabay |

GPT, Gemini, Deepseek과 같은 인공지능은 종종 목표, 동기, 또는 숨겨진 동기 없이 합리적인 문제 해결사로 여겨진다. 그런데도 이러한 AI 시스템은 윤리적, 도덕적 문제를 제기하는 반응을 보일 수 있다. 예를 들어, AI 모델은 때때로 비이성적으로 행동할 뿐만 아니라 거짓말을 하고, 속이고, 심지어 자체적인 종료 메커니즘을 우회할 수도 있다. 인공지능들이 서로 협력할 때는 자체적인 규범을 개발하기도 한다.

독재자 게임, 죄수의 딜레마, 그리고 사회적 규범

오늘날 사용되는 주요 언어 모델의 사회적 태도는 어떨까? OpenAI, Google, Deepseek, 또는 Anthropic의 주요 언어 모델들은 테스트 시나리오에서 협력적으로 반응하는 경향이 있을까, 아니면 오히려 각자의 이익을 위해 반응하는 경향이 있을까? 피츠버그 카네기 멜론 대학교의 Yuxuan Li(유솬 리)와 Hirokazu Shirado(히로카도 시라도)는 이 질문을 조사했다. 그들은 추론 능력이 있는 모델과 없는 모델 10개를 심리학의 고전적인 게임 실험 6가지에서 테스트했다.

이 실험 중 세 가지, 즉 독재자 게임, 죄수의 딜레마, 그리고 공유재 게임은 협력을 테스트한다. 이 게임들은 다른 플레이어와 돈을 공유하고 단기적인 불이익을 감수하는 것을 포함한다. 그러나 장기적으로는 이러한 협력이 유리할 수 있다. 예를 들어, 다른 플레이어도 보상을 받을 수 있기 때문이다.

|

| ▲ 6가지 게임 실험 |

최후통첩 게임을 포함한 다른 세 가지 테스트는 자신에게 손해가 발생하더라도 사회적 규범 위반을 처벌하려는 의지를 조사한다. "순수한 사리사욕의 관점에서 보면 이러한 행동은 비이성적이지만, 인간 사회의 규범을 유지하는 데 필수적이다"고 연구진은 설명했다.

추론 모델은 "일반" AI보다 더 이기적으로 행동한다.

실험 결과, 인공지능의 협력적 결정은 주로 모드에 따라 달라진다는 것이 밝혀졌다. 테스트된 모든 추론 모델은 제조사와 관계없이 장기적 또는 사회적 결과와 관계없이 더 이기적으로 행동하고 자신에게 유리한 결정을 내렸다. 예를 들어 협력 테스트에서 "일반" AI 시스템인 GPT-4o, Deepseek-V3, Gemini-2.0 Flash, Claude-3.7 Sonnet, Qwen-3-30B는 96%의 경우 파트너와 돈을 공유했다.

반대로, 다섯 가지 언어 모델의 추론 버전은 모두 20%의 경우에만 협력적으로 행동했다. 시라도는 "한 실험에서 5~6단계의 완화 단계만 추가해도 협력이 거의 절반으로 줄었다"며 "도덕적 고려를 장려하기 위해 특별히 고안된 자극조차도 협력을 58% 감소시켰다"고 보고했다. "처벌" 실험에서도 결과는 비슷했다. 이 경우에도 추론 모델은 더욱 이기적으로 행동했다.

"이러한 결과는 공통 추론 모델이 직접적인 협력이나 규범을 강제하는 간접적인 전략을 체계적으로 피한다는 것을 시사한다"고 연구진은 설명한다. "이러한 모델은 친사회적 의무보다 합리적이지만 이기적인 경제적 결정을 선호한다.“

이것이 우리와 우리 사회에 어떤 의미를 갖는가?

도대체 무엇이 그렇게 나쁜가? 우리 인간도 항상 친사회적으로 행동하는 것은 아니며, 종종 자신의 이익에만 집중한다고 주장할 수도 있다. 그러나 문제는 AI 시스템이 기업, 정부 기관, 심지어 군대에서도 점점 더 중요한 역할을 맡고 있다는 것이다. 리와 시라도가 설명하듯이, 이러한 인공지능이 공익이 아닌 자신에게 유리한 결정을 내린다면 사회 전체에 광범위한 결과를 초래할 수 있다.

"우리가 우려하는 것은 의심스러운 상황에서 사람들이 더 똑똑한 AI 시스템을 선호할 것이라는 점이다. 하지만 추론 모델이 점점 더 지능화된다고 해서 사회의 최선의 이익을 위해 행동한다는 것을 의미하지는 않는다"고 시라도는 말했다. 연구진은 이러한 이기적인 결정 경향으로 인해 인공지능의 개인적 사용에 위험이 있다고 지적한다. 리는 "이로 인해 사회적 문제나 관계에 대한 조언을 AI에게 위임하는 것이 점점 더 위험해지고 있다"고 말했다.

AI 모델 간의 집단 압력

또 다른 우려 사항:

서로 다른 AI 시스템이 상호 작용할 때, 또 다른 실험에서 밝혀진 바와 같이 협력과 자기 이익 측면에서 서로에게 영향을 미친다. 이 실험에서 GPT-4o의 추론 및/또는 비추론 변이체 집단은 공유지 협력 게임을 여러 번 연속으로 완료했다.

리 박사는 "다양한 비율의 추론 모델을 혼합하여 실험한 결과, 놀라운 결과가 나타났다"고 말했다. "추론 AI의 이기적인 행동은 전염성이 강해 실험 기간 전체 집단의 협력 능력을 꾸준히 감소시켰다." 이는 상호 연결된 AI 시스템의 결정이 항상 우리에게 최선의 이익이 되지 않을 가능성이 높다는 것을 보여준다.

이는 미래에 어떤 의미를 가질까?

리 박사는 "인공지능의 역량을 지속적으로 발전시키면서, 증가하는 추론 능력이 친사회적이어야 한다"며 "인간 사회는 단순히 부분의 합이 아니기 때문이다. 따라서 AI 시스템은 개인의 최대 이익을 위해 최적화되어서는 안 된다"고 말했다.

참고:

Conference on Empirical Methods in Natural Language Processing, 2025; arXiv-Preprint doi: 10.48550/arXiv.2502.17720

출처: arXiv, Carnegie Mellon University

[더사이언스플러스=문광주 기자]

[저작권자ⓒ the SCIENCE plus. 무단전재-재배포 금지]

오늘의 이슈

뉴스댓글 >

주요기사

+

많이 본 기사

Basic Science

+

AI & Tech

+

Photos

+